火绒高启发扫描技术迭代:引入深度学习能力,提升泛化识别精度

-

作者:火绒安全

-

发布时间:2025-11-17

-

阅读量:4267

目前,病毒与恶意软件的隐蔽性、复杂性不断升级,传统的检测方法面临严峻挑战。面对这一趋势,火绒团队引入了高启发扫描技术,近期我们完成了高启发查杀模型的一次重要迭代升级。

经过技术钻研与反复验证,我们尝试将核心引擎从原来的 LightGBM(一种机器学习框架)升级为带有自注意力机制的Transformer(一种深度学习模型)的新架构。这一努力带来了一些积极的信号。在内部基准测试中,新模型的误报率从13.80%降至0.8087%,同时病毒样本召回率也提升了超过10个百分点,我们视其为一次有价值的“渐进式改进”。虽然前路依然漫长,但我们相信在充满挑战的数字世界中,唯有保持静心深耕的态度,才能构筑起一道更值得信赖的安全防线。

目前,我们已将此模型更新至客户端 6.0.8.0 版本。若您在使用以往版本并想体验新的扫描技术,可通过检查更新升级至此版本。

注意:需在查杀设置中勾选启用高级启发式扫描功能,来体验我们的优化后的模型。

一.摘要

使用Machine Learning(机器学习)对二进制文件进行安全分析,这是一个有趣且极具挑战性的领域。众所周知,无论是Windows下的PE文件(如.exe,.dll),还是Linux下的ELF文件(如.so),均是现代操作系统的基石。而此类文件也是恶意软件传播的核心载体。

一直以来,火绒都在深入探索可能的反病毒范式。从基于敏感特征的模式匹配到专家手工设计的启发式规则,我们一直在尝试捕捉那些隐藏在指令序列与系统行为背后的异常模式,在复杂的系统中精准识别潜在的威胁。

然而,攻击者同样在进化。这正是这场攻防战的残酷之处,也使得我们必须不断探索检测技术的边界。

而机器学习在病毒检测领域的应用是火绒的一个重要探索方向,我们尝试借助这种技术让模型从大量样本中学习、提炼出抽象的“安全语义”,从而在手工设计规则之外具备一种更具泛化能力的“理解力”。在不断优化的过程中,我们希望构建的,不仅是能识别病毒外在形态的工具,而是能从本质上区分文件“善”与“恶”的智能体,让它与专家经验、规则引擎协同作战,共同应对那些善于伪装的未知威胁。

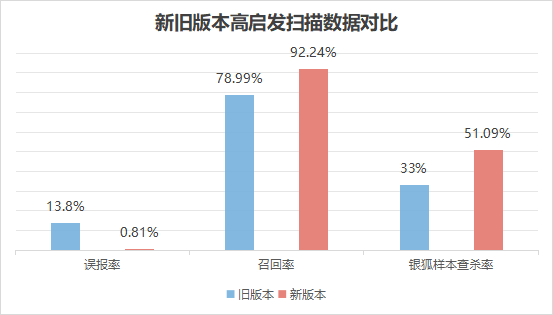

这一次,我们对高启发式扫描进行了全方位的改进,各项指标在火绒基准数据集上均有明显改善:

新模型的误报率从13.80%下降至0.8087%

病毒样本召回率从78.99%提升至92.2412%

银狐样本查杀率从33.00%提升至51.0908%

然而,某些特定类别的病毒样本集上,召回率有一定程度的下降,这指明了我们下一步的优化方向。

注:以上测试数据基于火绒基准数据集(约1200万样本)实测得出,可能存在一定误差。

二.基准模型:从LightGBM开始

这是火绒对机器学习应用在病毒查杀领域的一次初步尝试,当时我们选择了LightGBM作为一个起点。

在启动后,我们的团队遇到了诸多问题,比如:

一个样本到底是什么类型?

面对海量的特征,如何找到哪些是真正重要的?

病毒类型太多了,我们难道要让模型全部区分吗?

面对各种问题,我们想走出第一步,就需要“化繁为简”,也可以说是一种“妥协”。

标准化:抹平不同来源的命名差异。

粗粒度化:放弃了对子家族的精细区分,将它们合并成几个具有类似行为的大类。

特征工程:我们能提取出的特征的量级非常大,这对于一个机器学习算法来说完全无法处理,我们利用各种方式筛选出一小部分特征,只用这一部分特征来描述样本。

去重:如果两个(或更多)样本最终生成的特征向量是完全一样的,我们就只保留一个。

我们在这样一个流程下构建了一个基准数据集,采取各种策略完成了模型的训练。回顾整个流程——标签粗粒度化、特征启发式过滤、样本特征级去重——我们不难发现,这整个方案链条,是由一系列的“工程妥协”构建起来的。它在算法上或许并不“优美”,每一步都存在“丢失信息”或“引入偏见”的风险,但是它或许是一个良好的起点,是因为它在“理想”和“现实”之间,找到了一个务实的平衡点,用一个可控的、近似的、有损的方案,去解决一个原始的、开放的、困难的问题。

三.新的开始:拥抱Attention(自注意力机制)

火绒团队没有停留在起点,并不断尝试新的方法,而这次我们带来了优化后的高级启发式扫描。

它采用了全新的特征提取引擎以及基于Transformer Encoder的深度学习模型,在我们的测试数据上,误报率降低为基准模型的十分之一(13.80%下降至0.81%),而报出率则提升了13.25%(病毒样本召回率从78.99%提升至92.24%)。

而为了做到这样的性能提升,我们对高启发扫描功能做了非常多的改动,接下来我们将详细介绍一些相关的技术细节。

1.二进制文件的“基因序列”

引擎可以提取样本的特征序列,无论是PE还是ELF,都称之为样本的基因。基因描述了样本的结构特征和数据代码特征,而这样一个基因序列其实非常类似自然语言,只不过编码它的不再是Abandon这样的单词,而是一长串特征序列。要识别病毒,其实就是要找到这个序列的“行为模式”和“内在结构”。我们不用死记硬背病毒的“长相”,而是让模型尝试去理解它。

至此,我们成功地将一个二进制文件分析问题,转化成了一个序列分析问题。

2.为什么是Transformer?

在序列建模范畴内,可供选择的模型众多,诸如经典的循环神经网络(RNN),亦或是卷积神经网络(CNN)。

然而近年来,若论及最为适宜的模型,无疑当属Transformer。Transformer最为核心的优势在于其自注意力机制,该机制能够捕捉序列中任意两个元素间的长距离依赖关系,这对于我们的任务至关重要。

一个恶意软件的行为逻辑可能是由文件中相隔很远的两段代码共同决定的。比如,文件头部的一段代码负责解密,文件末尾的另一段代码是被解密出来的恶意载荷。传统的RNN或者CNN模型,由于其固有的局部性偏见,很难有效捕捉到这种远距离的依赖。而Transformer天生就是为此设计的,它能从全局视角审视整个特征序列,从而更精准地识别出潜藏的恶意模式。

因此,我们决定采用一个Encoder-Only的Transformer架构做为我们模型的主干。

四.一些难点和解决方案

1.如何嵌入特征

当我们兴致勃勃地准备搭建模型时,一个巨大的技术障碍摆在了面前:Vocabulary(词表)规模

特征提取引擎所可能产生的特征数量极为庞大,若直接针对如此规模的词表构建一个Embedding(嵌入)层,模型的参数量将急剧增加。在此情况下,不说在终端设备上运行模型,即便进行模型训练,都是难以达成的任务,我们必须想办法绕过这个障碍。

经过一番讨论,我们参考NLP的思路设计出了一个比较巧妙的解决方案:通过特征拆分的方式,将词表的规模缩小到了一个可以接受的程度。

2.构建数据集

这是一个非常重要的点,没有好的数据集,设计什么样的模型都是无用功。

此次吸取了以前的经验,我们筛选了诸多样本,设计了复杂的规则来标准化标签,并通过多数投票的方法最终确定样本的类别,最终将所有样本分成10种特定的类型,相对于以前用的数据集,量级和质量对比以前都有了一定程度的提升。

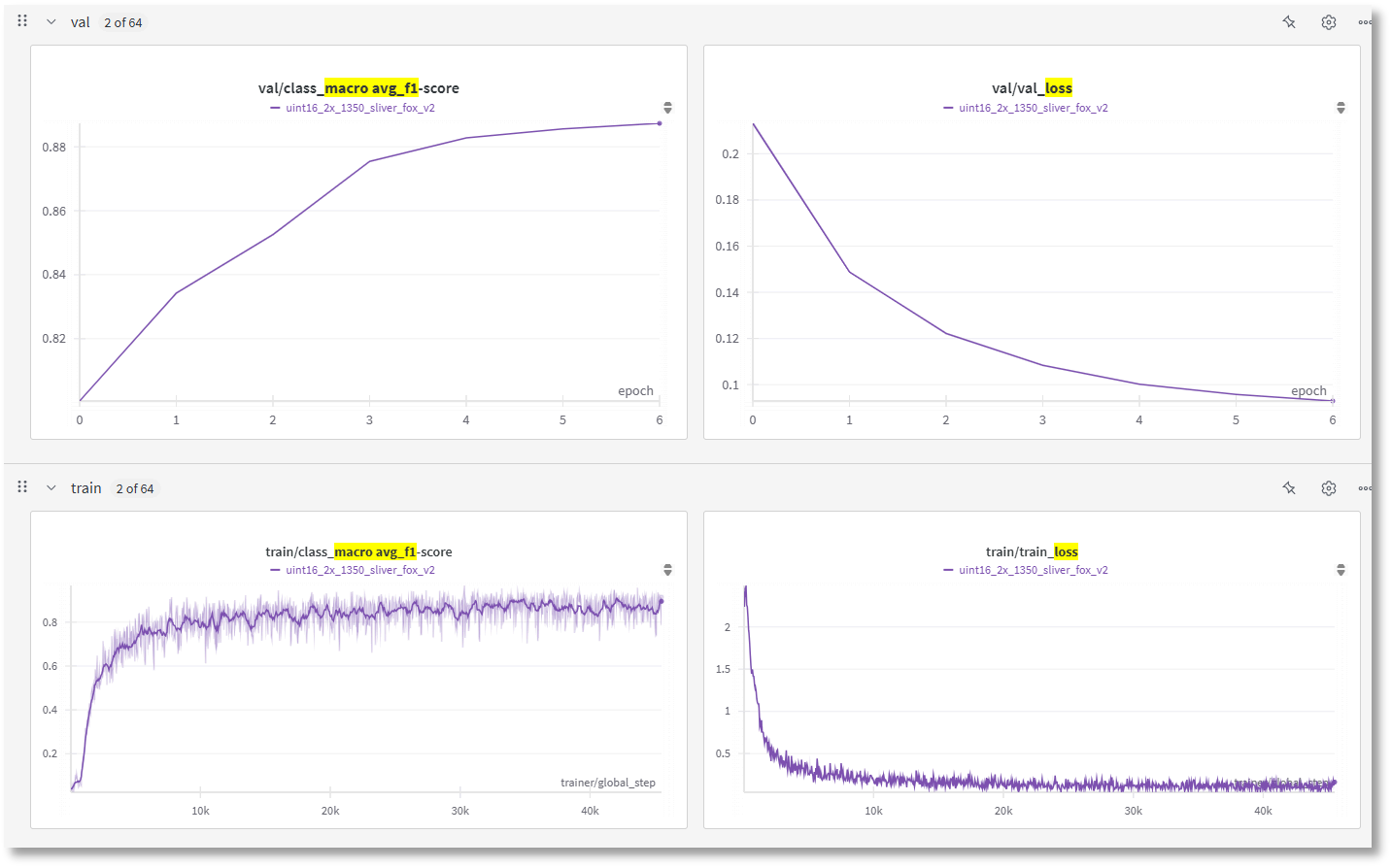

3.训练指标

经过对训练策略、参数的多轮调整后,训练没有任何损失尖峰,模型最终收敛到了相对稳定的状态。

五.工程化

1.误报控制

高启发在我们内部的测试结果中,误报相较于其他引擎而言是较高的。为了控制误报,我们设计了下面这种策略:模型会告诉我们一个样本是否是病毒的概率,而更高的概率显然比低概率更可信。

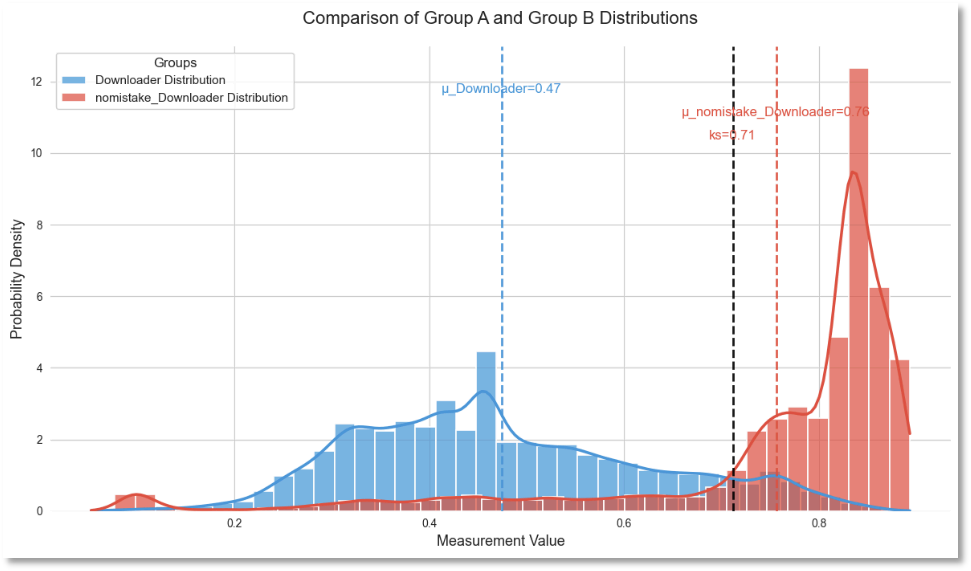

下图中是我们对某一类样本作出的误报概率分布直方图(蓝色)和报出概率分布直方图(红色),也支持了我们的观点。所以我们为模型设定了一些基准阈值,减少误报。

2.部署

历经这样一系列步骤,模型训练大体上已完成。该模型包含880万的参数,其体积仍高达35.313MB,依旧偏大。因此,接下来的工作重心自然就转向了模型压缩与优化。思路主要为以下两点:

格式转换:首先,将模型导出为 ONNX 格式。这是目前跨平台推理的标准方案,能让我们摆脱对特定训练框架的依赖。

模型量化:仅仅导出是不够的,体积的缩减主要依赖于量化。我们接着对导出的 ONNX 模型进行了 8-bit 量化。

经过这些调整,模型体积被成功压缩到了9.66MB。我们针对PE、ELF两种文件类型分别训练了模型,模型的总体积不超过20MB。同时开发团队为了让模型在不同设备上能平稳运行,对各个系统版本以及CPU都进行了适配,并且在未来也考虑支持NPU加速。

六.火绒,只为您提供更精准的守护

为了更好地平衡高启发扫描的稳定性并减少误报,我们在此次优化中暂时移除了对脚本类文件的扫描支持。火绒团队将持续打磨这项技术,未来会为大家带来更精准、更可靠的安全体验。

目前这版模型已经完成训练,但我们深知仍有提升空间——例如当前 0.8087% 的误报率在病毒检测中仍然偏高。火绒会持续投入技术优化,不断挖掘高启发扫描的更多潜力,敬请期待。

在使用高启发扫描时,若您遇到使用方面的问题,可随时联系火绒官方运营人员,我们将协助您解决问题。

火绒官方论坛 https://bbs.huorong.cn/

火绒官方服务热线 400-998-3555(法定工作日8:30-20:30,法定节假日9:30-18:30)

火绒安全团队

2025年11月17日